اگر بسیاری از شرکت های فناوری امیدوارند که هوش مصنوعی آینده به چشم عینک AR و سایر پوشیدنی ها از چشم ما نگاه کند ، آنها باید یاد بگیرند که چگونه از دیدگاه انسان استفاده کنند. البته ما به آن عادت کرده ایم ، اما به طور قابل ملاحظه ای فیلم ویدئویی اول شخص از کارهای روزمره وجود ندارد-به همین دلیل است که فیس بوک چند هزار ساعت را برای مجموعه داده جدید در دسترس عموم جمع آوری کرد.

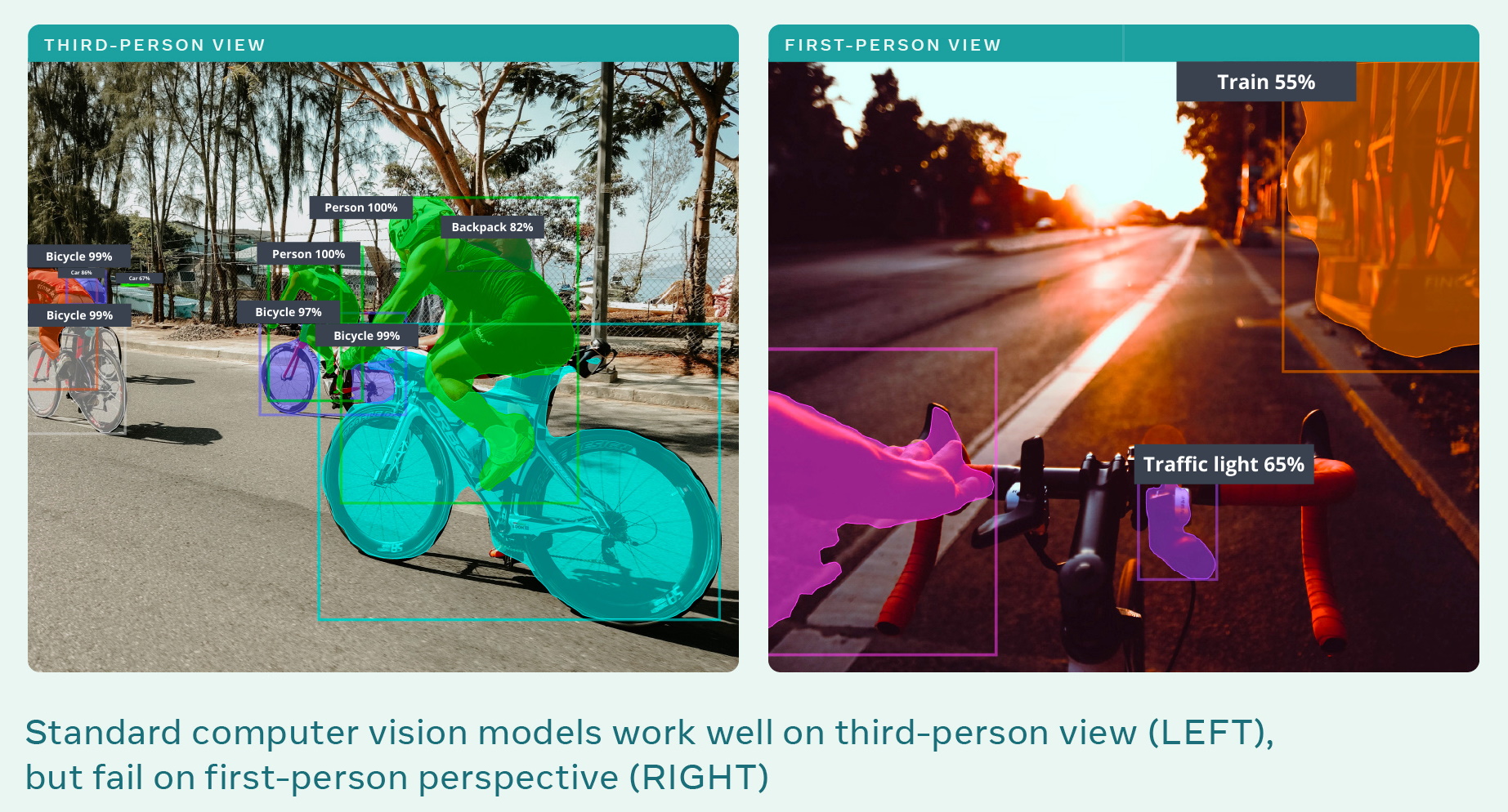

چالشی که فیسبوک در تلاش برای کنترل آن است این است که حتی چشمگیرترین مدل های تشخیص شیء و صحنه امروزه تقریباً منحصراً در دیدگاه های شخص سوم آموزش دیده اند. بنابراین می تواند شخصی را که در حال آشپزی است تشخیص دهد ، اما تنها در صورتی که آن شخص را در آشپزخانه ایستاده ببیند ، نه اگر منظره از چشم شخص باشد. یا دوچرخه را تشخیص می دهد ، اما نه از دیدگاه سوارکار. این یک تغییر چشم انداز است که ما آن را بدیهی می دانیم ، زیرا این بخشی طبیعی از تجربه ما است ، اما رایانه ها آن را بسیار دشوار می دانند.

راه حل مشکلات یادگیری ماشین عموماً داده های بیشتر یا بهتر است ، و در این صورت داشتن هر دوی آنها ضرری ندارد. بنابراین فیس بوک با شرکای تحقیقاتی در سراسر جهان تماس گرفت تا ویدئوی اول شخص از فعالیت های رایج مانند آشپزی ، خرید مواد غذایی ، تایپ بند کفش یا صرف وقت گذرانی را جمع آوری کند.

13 دانشگاه همکار هزاران ساعت فیلم از بیش از 700 شرکت کننده در 9 کشور جمع آوری کردند و در ابتدا باید گفت که آنها داوطلب بودند و سطح دخالت و هویت خود را کنترل می کردند. هزاران ساعت توسط یک تیم تحقیقاتی که ویدیو را تماشا ، ویرایش و با دست نوشته بودند ، به 3000 کاهش داد ، در حالی که فیلم خود را از محیط های صحنه ای که نمی توانستند در طبیعت ضبط کنند ، اضافه کرد. همه اینها در این مقاله تحقیقی شرح داده شده است.

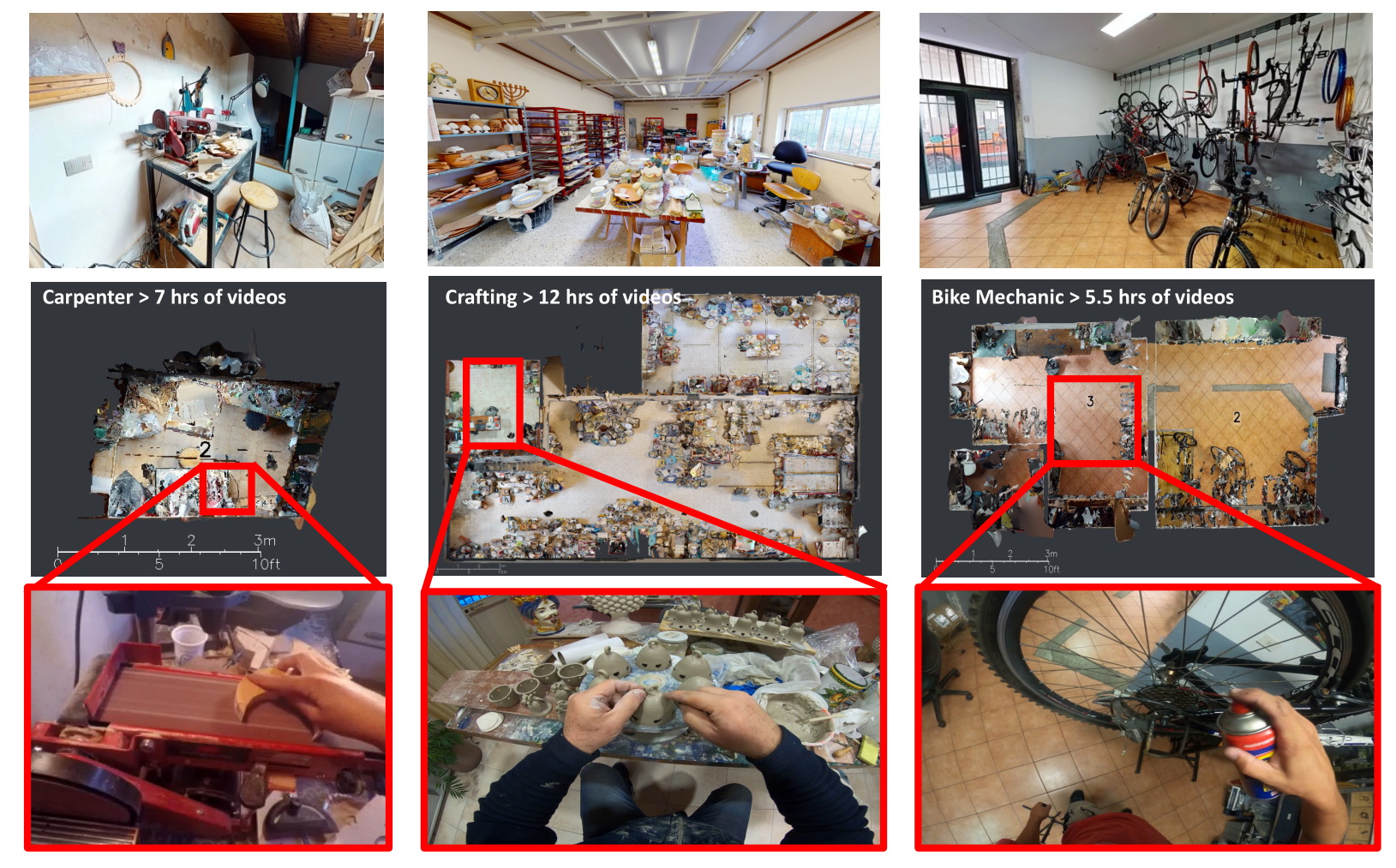

این فیلم با روش های مختلفی از دوربین های شیشه ای گرفته تا GoPros و سایر دستگاه ها ضبط شده است و برخی از محققان همچنین برای اسکن محیطی که فرد در آن کار می کرد انتخاب کردند ، در حالی که دیگران جهت نگاه و سایر معیارها را دنبال کردند. همه اینها وارد مجموعه داده ای از فیس بوک به نام Ego4D می شود که به طور رایگان در اختیار جامعه تحقیقاتی قرار می گیرد.

دو تصویر ، یکی نشان می دهد که بینایی کامپیوتر با موفقیت اشیاء را شناسایی می کند و دیگری نشان می دهد که در اول شخص شکست می خورد.

“برای تعامل سیستم های هوش مصنوعی با جهان به شیوه ای که ما انجام می دهیم ، حوزه هوش مصنوعی باید به یک الگوی کاملا جدید از درک اول شخص تبدیل شود. این به معنی آموزش هوش مصنوعی برای درک فعالیتهای روزمره از طریق چشم انسان در زمینه حرکت در زمان واقعی ، تعامل و مشاهدات چندحسی است. “

هرچقدر هم که باورش دشوار باشد ، این تحقیق و سایه های هوشمند Ray-Ban Stories کاملاً بی ارتباط هستند ، با این تفاوت که فیس بوک به وضوح تصور می کند که درک اول شخص به طور فزاینده ای برای رشته های مختلف اهمیت دارد. (هر چند می توان از اسکن های سه بعدی در شبیه ساز آموزشی شرکت Habitat AI استفاده کرد.)

گرومن به TechCrunch گفت: “تحقیقات ما به شدت با برنامه های کاربردی در واقعیت افزوده و روباتیک انگیزه دارد.” “درک شخص اول برای فعال کردن دستیارهای هوش مصنوعی در آینده بسیار مهم است ، به ویژه اینکه پوشیدنی هایی مانند عینک AR بخشی جدایی ناپذیر از نحوه زندگی و حرکت مردم در طول زندگی روزمره است. به این فکر کنید که اگر دستیاران دستگاه های شما بتوانند اضافه بار شناختی را از زندگی شما حذف کرده و جهان شما را از دید شما درک کنند ، چقدر سودمند خواهد بود. “

ماهیت جهانی فیلم جمع آوری شده یک حرکت بسیار عمدی است. این اساساً کوته بینانه خواهد بود که فقط شامل تصاویری از یک کشور یا فرهنگ واحد باشد. آشپزخانه های ایالات متحده با آشپزخانه های فرانسوی ، رواندا و ژاپنی متفاوت است. درست کردن یک ظرف با مواد تشکیل دهنده یکسان یا انجام یک وظیفه کلی یکسان (نظافت ، ورزش) ممکن است حتی بین افراد بسیار متفاوت باشد ، چه برسد به فرهنگ های مختلف. بنابراین ، همانطور که در پست فیس بوک آمده است ، “در مقایسه با مجموعه داده های موجود ، مجموعه داده Ego4D تنوع بیشتری از صحنه ها ، افراد و فعالیت ها را فراهم می کند ، که کاربرد مدل های آموزش دیده برای افراد در زمینه های مختلف ، قومیت ها ، مشاغل و سنین را افزایش می دهد. ”

نمونه هایی از فیس بوک ویدئوهای اول شخص و محیط هایی که در آن گرفته شده است.

پایگاه داده تنها چیزی نیست که فیس بوک منتشر می کند. با این نوع جهش در جمع آوری داده ها ، معمول است که مجموعه ای از معیارها را برای آزمایش نحوه استفاده خوب یک مدل از اطلاعات استفاده کنید. به عنوان مثال ، با مجموعه ای از تصاویر سگ و گربه ، ممکن است یک معیار استاندارد بخواهید که کارایی مدل را در تشخیص اینکه کدام است آزمایش کند.

در این مورد همه چیز کمی پیچیده تر است. به سادگی شناسایی اشیاء از دیدگاه اول شخص چندان دشوار نیست – در واقع فقط زاویه متفاوتی دارد – و همچنین جدید یا مفید نخواهد بود. آیا واقعاً به یک جفت لیوان AR نیاز دارید تا به شما بگوید “این یک گوجه فرنگی است”؟ نه: مانند هر ابزار دیگر ، یک دستگاه AR باید چیزی را به شما بگوید نکن بداند ، و برای انجام این کار نیاز به درک عمیق تری از چیزهایی مانند نیت ها ، زمینه ها و اقدامات مرتبط دارد.

در این راستا ، محققان پنج وظیفه را مطرح کردند که از نظر تئوری به هر حال می توان با تجزیه و تحلیل این تصویر اول شخص انجام داد:

- حافظه اپیزودیک: ردیابی اشیاء و مفاهیم در زمان و مکان به گونه ای که سوالات دلخواه مانند “کلیدهای من کجا هستند؟” می توان پاسخ داد

- پیش بینی: درک توالی رویدادها به گونه ای که س questionsالاتی مانند “در دستور العمل بعدی چیست؟” می توان به آنها پاسخ داد یا مواردی را می توان به طور پیشگیرانه ذکر کرد ، مانند “شما کلید ماشین خود را در خانه گذاشته اید”.

- تعامل دست و جسم: شناسایی نحوه گرفتن و دستکاری افراد از اشیاء ، و آنچه در هنگام انجام آنها اتفاق می افتد ، که می تواند به حافظه اپیزودیک وارد شود یا شاید اقدامات ربات را که باید از آن اقدامات تقلید کند ، آگاه سازد.

- دیاریزاسیون سمعی و بصری: ارتباط صدا با رویدادها و اشیاء به طوری که گفتار یا موسیقی را می توان به صورت هوشمند برای موقعیت هایی مانند پرسیدن آهنگ در کافه یا آنچه رئیس در پایان جلسه گفت ، ردیابی کرد. (“Diarization” “کلمه” آنها است.)

- تعامل اجتماعی: درک اینکه چه کسی با چه کسی صحبت می کند و چه چیزی گفته می شود ، هم به منظور اطلاع از سایر فرایندها و هم برای استفاده لحظه ای مانند زیرنویس در یک اتاق پر سر و صدا با چند نفر.

البته اینها تنها برنامه ها یا معیارهای ممکن نیستند ، فقط مجموعه ای از ایده های اولیه برای آزمایش این است که آیا یک مدل هوش مصنوعی واقعی آنچه را که در یک ویدئوی اول شخص اتفاق می افتد دریافت می کند یا خیر. محققان فیس بوک روی هر وظیفه که در مقاله آنها توضیح داده شده است ، به عنوان یک نقطه شروع عمل کردند. همچنین در صورت موفقیت در این ویدئوی خلاصه تحقیق ، یک نمونه ویدئویی در آسمان از هر یک از این وظایف وجود دارد.

وی خاطرنشان کرد: در حالی که 3000 ساعت-که بیش از 250،000 ساعت محقق با دقت به صورت حاشیه نویسی شده است-بسیار بزرگتر از چیزی است که در حال حاضر وجود دارد ، هنوز فضای زیادی برای رشد وجود دارد. آنها در حال برنامه ریزی برای افزایش مجموعه داده هستند و به طور فعال شرکای خود را نیز اضافه می کنند.

اگر به استفاده از داده ها علاقه دارید ، چشم خود را بر وبلاگ Facebook AI Research بگذارید و شاید با یکی از افراد بسیار زیادی که در مقاله ذکر شده تماس بگیرید. زمانی که کنسرسیوم دقیقاً نحوه انجام این کار را مشخص کند ، در چند ماه آینده منتشر می شود.