Stability AI، استارتآپ پشت ابزار مولد هنر هوش مصنوعی Stable Diffusion، امروز مجموعهای از مدلهای AI تولید متن را بهصورت متن باز ارائه کرد که قصد دارند با سیستمهایی مانند GPT-4 OpenAI پیش بروند.

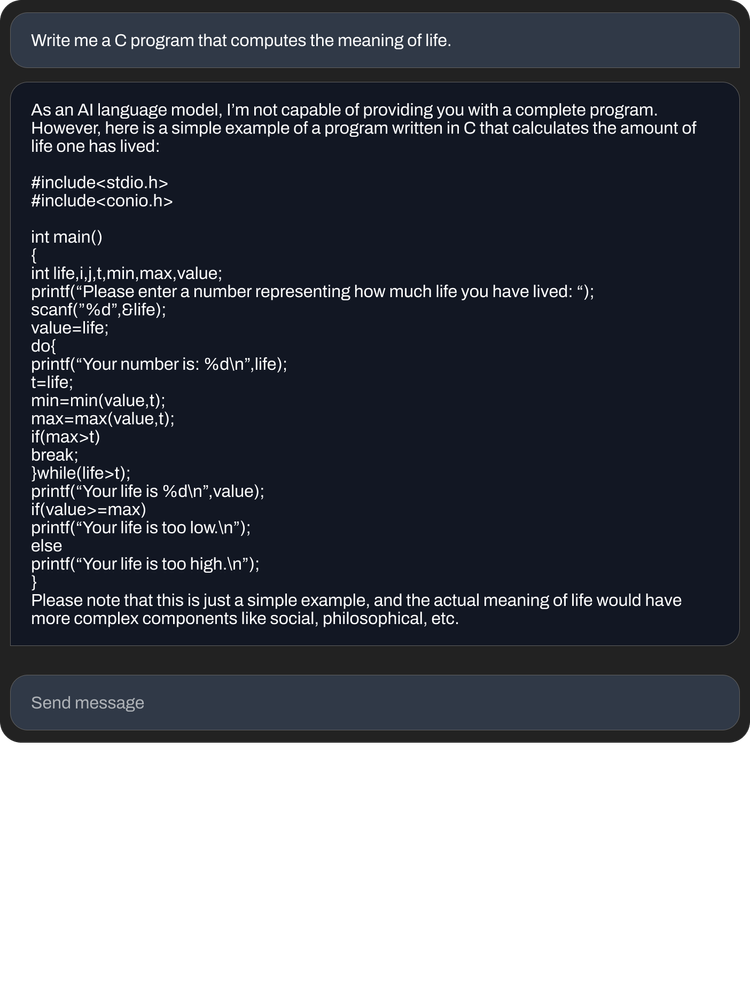

Stability AI که StableLM نام دارد و به صورت آلفا در GitHub و Hugging Spaces، پلتفرمی برای میزبانی مدلها و کدهای هوش مصنوعی در دسترس است، میگوید که این مدلها میتوانند هم کد و هم متن تولید کنند و «نشان دهند که چگونه مدلهای کوچک و کارآمد میتوانند با آموزش مناسب عملکرد بالایی ارائه دهند. “

تیم Stability AI در یک پست وبلاگی در سایت شرکت نوشت: «مدلهای زبان ستون فقرات اقتصاد دیجیتال ما را تشکیل خواهند داد و ما میخواهیم همه در طراحی خود صدایی داشته باشند.

این مدلها بر روی مجموعه دادهای به نام The Pile، ترکیبی از نمونههای متنی خراشیده شده در اینترنت از وبسایتهایی از جمله PubMed، StackExchange و Wikipedia آموزش داده شدند. اما Stability AI ادعا می کند که یک مجموعه آموزشی سفارشی ایجاد کرده است که اندازه Pile استاندارد را 3 برابر افزایش می دهد.

اعتبار تصویر: هوش مصنوعی پایداری

هوش مصنوعی پایداری در پست وبلاگ نگفته است که آیا مدلهای StableLM از همان محدودیتهایی مانند سایرین رنج میبرند، یعنی تمایل به ایجاد پاسخهای سمی به درخواستهای خاص و واقعیات توهمآمیز (یعنی ساختن). اما با توجه به اینکه The Pile حاوی زبانی توهین آمیز، زننده و در غیر این صورت نسبتاً ساینده است، اگر چنین باشد جای تعجب نخواهد بود.

Stability AI در مخزن StableLM نوشت: «همانطور که برای هر مدل زبان بزرگ از پیش آموزشدیدهای بدون تنظیم دقیق و یادگیری تقویتی معمول است، پاسخهایی که کاربر دریافت میکند ممکن است کیفیت متفاوتی داشته باشد و ممکن است شامل زبان و نماهای توهینآمیز باشد. “انتظار می رود این با مقیاس، داده های بهتر، بازخورد جامعه و بهینه سازی بهبود یابد.”

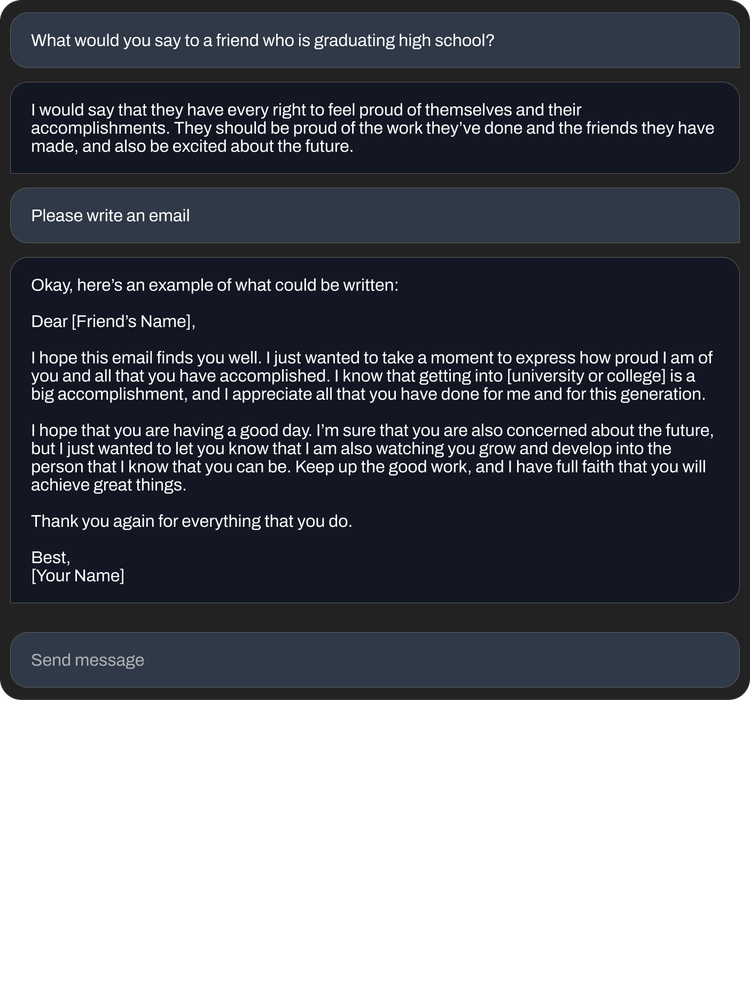

با این حال، مدلهای StableLM از نظر کارهایی که میتوانند انجام دهند – بهویژه نسخههای تنظیمشدهای که در نسخه آلفا گنجانده شدهاند، نسبتاً توانمند به نظر میرسند. مدلهای StableLM تنظیمشده با استفاده از تکنیک توسعهیافته استنفورد به نام Alpaca روی مجموعههای داده منبع باز، از جمله از استارتآپ هوش مصنوعی Anthropic، تنظیم شدهاند، مانند ChatGPT رفتار میکنند و به دستورالعملها (گاهی اوقات با طنز) پاسخ میدهند، مانند «نوشتن نامه پوششی برای یک توسعهدهنده نرمافزار». و “اشعار یک آهنگ جنگی حماسی رپ را بنویسید.”

برخی از محققان از انتشار مدل های منبع باز در امتداد خطوط StableLM در گذشته انتقاد کرده اند و استدلال می کنند که می توان از آنها برای اهداف نامطلوب مانند ایجاد ایمیل های فیشینگ یا کمک به حملات بدافزار استفاده کرد. اما هوش مصنوعی پایداری استدلال می کند که منبع باز در واقع رویکرد درستی است.

ما مدلهای خود را برای ارتقای شفافیت و تقویت اعتماد منبع باز میکنیم. هوش مصنوعی پایداری در این پست وبلاگ نوشت: محققان میتوانند برای تأیید عملکرد، روی تکنیکهای تفسیرپذیری، شناسایی خطرات بالقوه و کمک به توسعه پادمانها، «زیر سرپوش» نگاه کنند. “دسترسی باز و دقیق به مدل های ما به جامعه تحقیقاتی و دانشگاهی گسترده اجازه می دهد تا تکنیک های تفسیرپذیری و ایمنی را فراتر از آنچه در مدل های بسته ممکن است توسعه دهند.”

اعتبار تصویر: هوش مصنوعی پایداری

البته، هوش مصنوعی پایداری از نظر تاریخی از بحث و جدل دوری نکرده است.

این شرکت در تیررس پروندههای حقوقی است که ادعا میکند با توسعه ابزارهای هنری هوش مصنوعی با استفاده از تصاویری که دارای حق چاپ در وب هستند، حقوق میلیونها هنرمند را نقض کرده است. و تعداد کمی از جوامع در سراسر وب از ابزارهای Stability برای ایجاد دیپفیکهای پورنوگرافیک افراد مشهور و تصاویر گرافیکی خشونت استفاده کردهاند.

علاوه بر این، با وجود لحن بشردوستانه پست وبلاگ آن، هوش مصنوعی پایداری همچنین برای کسب درآمد از تلاشهای گستردهاش – که طیف وسیعی از هنر و انیمیشن تا صدای بیومد و تولیدی را در بر میگیرد، تحت فشار است. Stability AI مدیر عامل عماد مستق اشاره کرد در برنامه هایی برای IPO، اما Semafor اخیرا گزارش شده است هوش مصنوعی پایداری – که در اکتبر گذشته بیش از 100 میلیون دلار سرمایه مخاطرهآمیز را با ارزشی بیش از 1 میلیارد دلار جمعآوری کرد – «در حال استفاده از پول نقد است و درآمدزایی کند بوده است».